|

|

|

|

|

|

LES ACCÉLÉRATEURS DE PARTICULES |

|

|

| |

|

| |

LES ACCÉLÉRATEURS DE PARTICULES

Comment fonctionne un accélérateur de particules?

En utilisant le champ électrique et le champ magnétique, les particules dans un accélérateur sont tour à tour produites, accélérées, focalisées et guidées vers les endroits requis.

LES "MISSIONS" D'UN ACCÉLÉRATEUR

DE PARTICULES

Accélérer c'est augmenter la vitesse. Dans un accélérateur de particules, un faisceau de particules électriquement chargées, par exemple des électrons (charge électrique négative) ou bien des ions (charge électrique positive ou négative), à une énergie donnée, est accéléré. L’énergie correspond ici à une énergie cinétique, c’est-à-dire l’énergie liée à la vitesse. L'unité utilisée est l'électronvolt (eV), qui est l'énergie donnée à un électron accéléré à partir de sa position de repos par une tension de 1Volt.

Dans un accélérateur de particules, accélérer ne suffit pas. Il faut aussi que le nombre de particules à l’endroit d’utilisation soit suffisant et que la taille et la divergence du faisceau ne soient pas trop grandes. Ce qui n'est pas une tâche aisée étant donné que les charges électriques de même signe se repoussent entre elles, et se perdent sur les parois, pouvant activer ou détériorer les équipements utilisés pour transporter le faisceau.

Dans un accélérateur on ne fait donc pas qu'accélérer. On doit aussi produire les particules, les guider vers les endroits voulus et les focaliser convenablement (c’est-à-dire optimiser la taille et la divergence du faisceau) et les accélérer.

LES ÉTAPES DU FONCTIONNEMENT

D’UN ACCÉLÉRATEUR DE PARTICULES

Production de particules chargées

L’une des premières étapes est la production de particules chargées. Il s'agit de séparer les électrons des noyaux et de donner une première accélération à l'une des deux espèces chargées voulue. La séparation des charges se fait en général par chauffage, soit avec un courant électrique à travers un métal ou un fort champ électrique, soit avec une onde électromagnétique à travers un gaz. On applique alors une tension électrique pour attirer les charges à l'extérieur de la source.

Guidage des particules

Un dipôle, aussi appelé aimant de courbure, est un élément magnétique de guidage dont le rôle est de dévier la trajectoire des électrons. Il y a 36 dipôles dans le booster et 32 dans l’anneau de stockage (ici : un dipôle du booster) de SOLEIL. Dans l’anneau de stockage ce sont également des sources de rayonnement synchrotron, puisque les électrons produisent ce rayonnement quand leur trajectoire n’est pas rectiligne et uniforme. © Synchrotron SOLEIL – Christophe Kermarrec

Il faut ensuite courber la trajectoire des particules, soit parce qu'on est dans un accélérateur circulaire, soit parce qu'il faut amener les particules à l'endroit de la collision ou de la cible à irradier. On emploie pour cela un champ magnétique qui exerce une force perpendiculaire à la direction de déplacement des particules chargées. Les particules chargées sont alors obligées de s'enrouler autour de l'axe du champ magnétique.

On peut utiliser des aimants permanents mais dans la très grande majorité des cas, ce sont des électro-aimants appelés "dipôles" qui sont mis en œuvre. Le champ magnétique est créé par deux bobines dans lesquelles circule un courant électrique très intense pouvant atteindre plusieurs centaines d’Ampères. Les champs utilisés sont de l'ordre de 10 000 Gauss (1 Tesla) pour les dipôles à température ambiante et 10 à 20 fois plus pour les dipôles supraconducteurs (température cryogénique). Pour mémoire, le champ magnétique terrestre est de 0,5 Gauss.

Focalisation des particules

Pour exercer une force perpendiculaire à la direction de déplacement des particules, c'est le champ magnétique qui est employé, notamment à l’aide d’électro-aimants. Deux configurations sont possibles :

* Solénoïde. C'est une longue bobine électrique créant un champ magnétique axial autour duquel les particules chargées sont obligées de s'enrouler et sont donc par la même occasion focalisées car elles doivent rester proches de l'axe.

*

* Quadrupôle. La configuration du champ magnétique est générée par quatre bobines électriques. Les particules qui passent à travers sont focalisées dans un plan (horizontal par exemple) et défocalisées dans l'autre (vertical par exemple). Une succession de quadrupôles (de focalisations-défocalisations) permet de régler efficacement la taille et la divergence du faisceau de particules en horizontal et vertical. Le champ magnétique exerçant une force perpendiculaire à la trajectoire de la particule chargée, il ne permet pas de changer la vitesse de celle-ci.

Accélération des particules

Pour accélérer les particules, on doit obligatoirement utiliser un champ électrique qui exerce sur les particules une force parallèle au champ. Si on oriente le champ parallèle au déplacement des particules, sa force sera alors accélératrice. Si on oriente le champ perpendiculairement, il sera focalisant ou défocalisant. Contrairement au champ magnétique donc, un champ électrique est capable de fournir de l'énergie à des particules chargées.

Dans les premiers accélérateurs, c'est un champ électrostatique créé entre des surfaces conductrices chargées qui est utilisé. Or cela ne permet pas d'obtenir des champs très forts car on est limité par les problèmes de claquages (tels les éclairs d'orage).

Maintenant, de façon classique, ce sont des cavités résonantes qui sont utilisées, où une onde électromagnétique y est piégée. C'est le même principe que les caisses de résonance des instruments de musique pour les ondes sonores. Ici c'est une composante électrique qui doit être positionnée au niveau du passage du faisceau de particules.

Les cavités accélératrices à température ambiante peuvent fournir un champ électrique de plusieurs megaV/m et les cavités supraconductrices (température cryogénique) atteignent des champs 10 fois plus élevés.

Accélération et focalisation (presque) simultanées

Dans le cas d’un faisceau intense à basse énergie, typiquement à la sortie de la source de particules chargées, les forces répulsives entre particules de même charge électrique sont encore très fortes. On ne peut pas accélérer et focaliser séparément, car pendant le temps d'accélération, les particules peuvent déjà se disperser. On doit alors utiliser un dispositif appelé RFQ, Quadrupôle RadioFréquence qui permet d'accélérer et de focaliser successivement sur des longueurs très courtes de quelques cm. C'est une cavité résonante longue de 3 à 10 m, munie de 4 pôles finement sculptés en 3D sous la forme d'une ondulation. La période de cette ondulation est progressivement de plus en plus longue car les particules accélérées vont de plus en plus rapidement. L'onde électromagnétique qui y est piégée aura ainsi une composante électrique successivement parallèle et perpendiculaire au déplacement du faisceau sur une longueur de quelques cm, permettant d'accélérer et focaliser les particules chargées presque simultanément.

DOCUMENT cea LIEN |

| |

|

| |

|

|

|

LE LASER : UN CONCENTRÉ DE LUMIÈRE La fabrication de la lumière laser |

|

|

| |

|

| |

LE LASER : UN CONCENTRÉ DE LUMIÈRE

La fabrication de la lumière laser

Les lasers produisent une lumière domptée bien différente de la lumière ordinaire produite par le Soleil ou les ampoules. Les propriétés du laser vont être à la base d'applications utilisant ce type de lumière.

Publié le 30 juin 2015

Au service de la science, de la médecine, du transport de l’information, de l’industrie et au cœur de notre vie quotidienne, le laser est partout présent.

INTRODUCTION

Dans les années 1960 naissaient les premiers LASERs, acronyme de Light Amplification by Stimulated Emission of Radiation (amplification de lumière par émission stimulée de rayonnement). Très vite, leur lumière magique a trouvé de multiples applications. Les lasers se sont installés dans notre vie quotidienne : CD, DVD, dans nos imprimantes et les lecteurs de codes-barres des supermarchés. Ils font la beauté des spectacles qui portent leur nom. D’autres, dans l’industrie, coupent, soudent et percent. Les faisceaux rectilignes des lasers servent aussi à aligner des routes, des tunnels… En médecine, ils réparent ou brûlent les zones malades sans toucher aux parties saines. Mais pourquoi les lasers sont-ils capables de faire toutes ces choses alors que la lumière ordinaire, émise par le Soleil ou une ampoule, ne peut pas les réaliser ?

Le CEA travaille depuis longtemps sur toutes les formes de lasers. Les chercheurs les utilisent dans leurs travaux pour des applications classiques (alignement, perçage, spectroscopie…) et en développent de nouveaux pour des usages spécifiques et innovants. C’est le cas de nombreux lasers de puissance grâce auxquels ils étudient, par exemple, l’interaction d’une impulsion lumineuse très intense avec la matière. Outils indispensables pour de nombreuses applications, il ne faut pourtant pas ignorer les risques associés à leur manipulation, puisqu’ils véhiculent de l’énergie, ni oublier les précautions d’utilisation.

COMPARAISON DE LA LUMIÈRE ORDINAIRE ET DE LA LUMIÈRE LASER

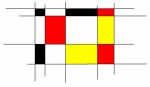

Les lasers produisent une lumière bien différente de la lumière ordinaire produite par le Soleil ou les ampoules. Le tableau ci-dessous dresse leurs portraits robots et liste leurs dissemblances.

L’ÉMISSION STIMULÉE

Un atome, un ion ou une molécule excité peut libérer son énergie par « émission spontanée » d’un photon.

Il existe un autre mode prévu par Albert Einstein en 1917. Une particule (atome, ion ou molécule) excitée, qui reçoit un photon de la même énergie que celui qu’elle pourrait émettre de manière spontanée, émet un photon par l’effet dit « d’émission stimulée ». La particularité de ce type d’émission est que le photon stimulé prend strictement les mêmes caractéristiques (couleur, direction et phase) que le photon incident, comme si le second était la photocopie du premier.

L’INVERSION DE POPULATION

L’émission stimulée agit donc comme une duplication de la lumière. En répétant de nombreuses fois ce phénomène, il est possible de créer une lumière qui est composée de photons tous identiques, de même couleur, émis dans la même direction comme s’ils étaient la copie conforme les uns des autres : c’est la lumière laser.

Les caractéristiques particulières de la lumière laser sont exploitées dans de multiples domaines.

Maquette 1/5 de la chaîne laser de la Ligne d’Intégration Laser (LIL). Elle a permis de développer des logiciels d’alignement systémique des divers éléments (amplificateurs, miroirs...). © A.Gonin/CEA

La seule découverte de l’émission stimulée n’a cependant pas été suffisante pour créer des lasers. En effet, dans la matière, les atomes, les ions ou les molécules sont beaucoup plus nombreux dans un état non excité que dans un état excité. Un photon incident a ainsi une probabilité plus grande d’être absorbé que d’engendrer un photon par émission stimulée. Pour produire de la lumière laser, il faut trouver un moyen de renverser la tendance et d’obtenir un milieu contenant plus de particules excitées que de particules au repos. Ce processus est appelé inversion de population.

Le physicien français Alfred Kastler, en 1949, a apporté une solution à ce problème : le pompage optique, qui permet de transférer de l’énergie lumineuse à des atomes. Ces résultats lui valurent le prix Nobel de physique en 1966. Le premier milieu utilisé a été le rubis : éclairé par de la lumière blanche, il absorbe une partie des couleurs (du vert au bleu) et émet de la lumière rouge (694,3 nanomètres de longueur d’onde), de manière stimulée ou non. Le pompage optique n’est pas la seule façon d’obtenir l’inversion de population, celle-ci peut aussi être provoquée, puis entretenue et par décharge électrique et certaines réactions chimiques.

Constant et ordonné, le faisceau laser reste monochromatique, fin et directionnel.

L’OSCILLATEUR LASER

Pour fabriquer la lumière laser, il faut une source d’énergie et un oscillateur laser.

L’oscillateur est une sorte de cylindre allongé avec un miroir à chacune de ses extrémités. Il est empli du milieu laser, matériau solide, liquide ou gazeux contenant des particules capables d’émettre des photons. Par exemple, le rubis est un milieu laser solide dont les atomes excitables sont ceux du chrome.

Comment l’oscillateur laser produit la lumière ?

Imaginons un photon émis spontanément dans le milieu laser dont la trajectoire est perpendiculaire aux plans des miroirs. En rencontrant une particule excitée, il va stimuler l’émission d’un deuxième photon. Les deux photons identiques peuvent à leur tour stimuler d’autres émissions de photons et ainsi de suite, jusqu’à ce que le groupe de photons rencontre le miroir. Leur trajectoire étant perpendiculaire au plan de celui-ci, ils seront renvoyés strictement en sens inverse et continueront de nouveau à provoquer des émissions stimulées. Dans cette réaction en chaîne, le nombre de photons identiques qui vont et viennent entre les miroirs va donc augmenter à chaque passage : la lumière laser est amplifiée. Pour que l’amplification soit efficace, il faut que les ondes de photons restent en phase après un aller-retour, c’est ce qui donne sa cohérence à la lumière. Pour que le faisceau sorte de l’oscillateur laser, l’un des deux miroirs est partiellement transparent, comme peut l’être un miroir sans tain. La plupart des photons sont réfléchis mais certains le traversent, permettant ainsi au faisceau laser de sortir.

Pour qu’un oscillateur produise de la lumière laser en continu, il faut que la source d’énergie, de type lumineuse, électrique ou chimique, soit elle-même continue. Après une rapide phase de mise en route, la lumière garde une puissance constante. Il existe des cavités laser capables d’émettre la lumière laser de manière discontinue, par impulsions brèves et intenses. On dit alors que le laser est impulsionnel.

LES AMPLIFICATEURS LASER

La lumière laser produite par un oscillateur peut, pour certaines applications, être utilisée directement. Mais dans le cas où il est nécessaire d’avoir une puissance beaucoup plus grande, il faut amplifier la puissance véhiculée par la lumière laser émise par l’oscillateur par une série d’amplificateurs. L’amplificateur est constitué d’un milieu laser. Son principe de fonctionnement est le même que celui de l’oscillateur. Les particules du milieu laser de l’amplificateur sont excitées par le faisceau laser sortant de l’oscillateur et les photons qui vont traverser l’amplificateur vont produire par réaction en chaîne de nombreux autres photons identiques : la puissance de la lumière laser est amplifiée. Pour obtenir la puissance recherchée, plusieurs amplificateurs sont placés sur la trajectoire du faisceau laser. Au fur et à mesure de l’augmentation de la puissance, il faut augmenter le diamètre du faisceau et des amplificateurs, pour éviter que les composants optiques (milieux laser en verre, miroirs, lentilles…), soumis à l’énergie grandissante de la lumière laser, ne soient endommagés. La série constituée de l’oscillateur, des amplificateurs et des autres composants optiques constitue une chaîne laser.

DOCUMENT cea LIEN |

| |

|

| |

|

|

|

Plongée dans le nanomonde |

|

|

| |

|

| |

Plongée dans le nanomonde

L’essor constant de la miniaturisation va de pair avec la mise au point de nouveaux microscopes, ouvrant la voie aux nanosciences et aux nanotechnologies.

Publié le 1 juillet 2012

Les possibilités offertes par la miniaturisation avaient été perçues très en amont, dès 1959, par le physicien Richard Phillips Feynman. Celui-ci avait émis l’hypothèse que l’homme pouvait manipuler les atomes et les utiliser soit pour stocker de l’information, soit pour créer des systèmes fonctionnels. L’idée était là, mais pas les instruments permettant de vérifier cette hypothèse.

En appliquant à l’électronique une loi économique datant de la fin du XIXe siècle, Gordon Moore, cofondateur d’Intel, estimait en 1965 que la cadence de miniaturisation des transistors intégrés sur une même puce suivrait une pente régulière. En 1974, une puce contenait 4 transistors intégrés. Aujourd’hui, cette même puce en contient des dizaines de millions, chacun de la taille de 100 nm. En 2020, selon la courbe de cette « loi de Moore », les transistors devraient atteindre 10 nm !

Grâce à cette miniaturisation, les industriels fractionnent le cœur des processeurs en plusieurs sous-unités travaillant parallèlement, augmentant ainsi les fonctionnalités des processeurs.

Selon la loi de Moore, d’ici à 2020, la taille des transistors devrait atteindre 10 nm, contre 100 nm aujourd’hui.

TOP-DOWN ET BOTTOM-UP

Cette volonté de miniaturisation est celle de la voie descendante, ou top-down. Le matériau est découpé, sculpté, gravé pour atteindre la dimension souhaitée, grâce à l’instrumentation élaborée et améliorée par l’homme, en vue d’atteindre le micromètre, puis le nanomètre. À l’inverse, la voie ascendante, ou bottom-up, permet d’assembler atome par atome des agrégats, puis des molécules, pour construire la matière. Cette voie est similaire à celle suivie par la Nature qui, à partir de molécules simples, a formé le monde du vivant durant les 4 milliards d’années d’évolution.

L’étude du nanomonde englobe :

* les nanosciences, qui étudient la composition de la matière, son assemblage et ses propriétés intimes à l’échelle du nanomètre ;

* les nanotechnologies, qui correspondent aux techniques et outils utilisés pour étudier ces nouvelles propriétés de la matière et pour réaliser de nouveaux dispositifs, objets et systèmes qui les exploitent.

DES OUTILS TRÈS FINS ET PRÉCIS

Pour manipuler des objets aussi petits, les outils doivent être très fins et précis. Le microscope à effet tunnel est l’un des premiers instruments créés afin de « voir » les atomes à la surface de la matière. Cet instrument comporte une pointe métallique extrêmement fine qui permet de cartographier, atome par atome, la surface d’un matériau. Il est uniquement utilisé pour l’observation de la surface des matériaux conducteurs. Une tension électrique, créant un courant d’électrons, est exercée entre la pointe et la surface. La surface est donc balayée à une distance de quelques nanomètres, la pointe capture les électrons qui transitent grâce à l’effet tunnel. Les variations de ce « courant tunnel » sont enregistrées et traitées par un ordinateur fournissant une image du relief de la matière, atome par atome (voir schéma ci-dessous). Ses inventeurs, les Suisses Gerd Binnig et Heinrich Rohrer, du laboratoire de recherche d’IBM à Zurich, ont été couronnés par le prix Nobel de physique en 1986.

Le microscope à effet tunnel

Le microscope à force atomique permet d’observer des matériaux non conducteurs, tels que les matériaux céramiques, polymères ou biologiques.

S’appuyant sur un dispositif semblable à celui qui équipait la tête de lecture des tourne-disques, il est 100 % mécanique. La pointe de ce microscope est fixée sur un bras de levier flexible, qui est en interaction avec la surface du matériau. Elle balaye la surface en suivant à très faible distance le relief. La déformation du levier, éclairé par un laser, est mesurée par un photodétecteur et enregistrée sur un ordinateur.

Dans un grand nombre d’expériences, les chercheurs ont recours à la puissance de calcul des supercalculateurs pour modéliser l’assemblage atomique et restituer ses propriétés propres. L’objectif est d’augmenter les connaissances en sciences de la matière ou du vivant et de constituer en amont des assemblages inédits ou de contrôler certaines propriétés.

DOCUMENT cea LIEN |

| |

|

| |

|

|

|

Le calcul et l'ordinateur quantiques |

|

|

| |

|

| |

Le calcul et l'ordinateur quantiques

Publié le 18 mai 2021

Si l'on ne dispose pas encore d’une véritable technologie d’ordinateur quantique, qui permettrait d'exploiter toute la puissance du calcul quantique, de nombreuses routes sont néanmoins explorées aujourd’hui. Toutes font encore face à des difficultés sans solution viable. Mais l’histoire du domaine a montré que des verrous considérés comme infranchissables finissaient par être levés. C’est pourquoi la recherche mondiale est plus active que jamais et les annonces publiques se multiplient, dans le cadre de ce qui est appelé aujourd’hui la "deuxième révolution quantique".

Le calcul quantique ambitionne d'utiliser les propriétés quantiques ultimes de la matière (la superposition, l'intrication et la non-localité) pour effectuer massivement des opérations sur des données grâce à l'ordinateur quantique. Il permettrait de ce fait de dépasser très largement les capacités offertes par les ordinateurs classiques.

LES QUBITS, AU COEUR DU CALCUL QUANTIQUE

Le calcul quantique s’appuie sur des qubits, pendants quantiques des bits classiques. D’un point de vue physique, les qubits sont des systèmes matériels pouvant être mis dans deux états quantiques distincts. Conformément aux lois de la physique quantique, le qubit peut être placé dans un ensemble continu de superpositions de ses deux états de base, contrairement au bit classique qui ne peut prendre que deux valeurs (0 ou 1).

Comme les bits classiques, les qubits peuvent être utilisés pour encoder une information et soumis à des portes quantiques (équivalents des portes logiques).

QU'EST-CE QU'UN BIT QUANTIQUE ?

Dans un ordinateur classique, l’information est stockée dans un ensemble (registre) de cases mémoires, les bits, dont la valeur est soit 0, soit 1. Un bit quantique (qubit) a, quant à lui, deux états quantiques |0> et |1>, séparés par une différence d’énergie définissant sa fréquence (fQB), et peut être à la fois dans ces deux états. Au cours d’un algorithme (succession d'opérations dites « portes logiques »), le registre de qubits se trouve dans une superposition quantique de tous ses états possibles (|00...0>, |10...0>, |11...1>, |10...1>), permettant un calcul massivement parallèle.

Le fonctionnement d'un ordinateur quantique

Atouts et difficultés de la recherche sur le calcul quantique

La promesse d’un parallélisme massif

Grâce à ses propriétés quantiques (superposition et intrication), un registre de N qubits se trouve à un instant donné dans une superposition de ses 2N configurations de base. Un registre de N bits ne peut, lui, se trouver que dans une seule d’entre elles à la fois.

Toute opération appliquée à un registre de N qubits s'effectuerait donc en parallèle sur les 2N états, là où un ordinateur classique doit traiter l’opération de façon séquentielle. Ce parallélisme massif ouvre des horizons extrêmement prometteurs, laissant espérer une résolution beaucoup plus rapide de certains problèmes ou l’identification d’une solution à des problèmes aujourd’hui insolubles.

L'INTRICATION QUANTIQUE

L’intrication quantique est un phénomène dans lequel deux particules (ou groupes de particules) forment un système unique, et présentent des états quantiques dépendant l'un de l'autre quelle que soit la distance qui les sépare.

Décohérence et correction d’erreurs

De très nombreux obstacles physiques et technologiques se dressent toutefois sur la route du calcul quantique, à commencer par la fragilité de l’état de superposition qui lui est nécessaire. Toute interaction, aussi minime soit-elle, avec l’extérieur (que ce soit par le biais d’interactions environnementales ou de mesures effectuées sur le système) a pour effet de détruire la superposition quantique : c’est la décohérence. La difficulté s’aggrave à mesure que le nombre de qubits intriqués augmente : le temps de cohérence d’un état intriqué de N qubits est en effet environ N fois plus court que celui d’un seul qubit.

Or, les interactions avec l’environnement ne peuvent par ailleurs être réduites à zéro, car elles sont nécessaires pour appliquer des opérations logiques sur les qubits et en effectuer la lecture. En pratique, il faut donc corriger les erreurs.

L'histoire de l'ordinateur quantique

Au début des années 1980, le Nobel de physique Richard Feynman est le premier à pressentir les possibilités faramineuses d’un ordinateur capable de tirer parti des lois quantiques.

Dès les années 1990, plusieurs théoriciens démontrent que certains calculs verraient leur résolution accélérée dans des proportions inouïes s’il était possible de les implémenter sur des bits quantiques, aussi appelés qubits, plutôt que sur des bits classiques. À condition, bien sûr, de disposer d’un processeur quantique pour les utiliser, processeur dont personne ne sait à l’époque à quoi il pourrait ressembler.

Molécules en phase liquide, ions piégés par des faisceaux laser, impureté dans les solides… les idées commencent à fuser dans les laboratoires de physique pour définir ce qui pourrait devenir les briques de base d’un futur ordinateur quantique, à l’instar des transistors de la microélectronique classique.

QUELS SONT LES ENJEUX DE LA RECHERCHE SUR LE CALCUL ET L'ORDINATEUR QUANTIQUES ?

Au XXe siècle, la mise au jour de la physique quantique a révolutionné notre conception du monde mais aussi notre mode de vie avec ses applications : lasers, transistors, circuits intégrés.

Une deuxième révolution quantique advient à l’aube du XXIe siècle. Elle regroupe des recherches visant à concevoir et à réaliser des dispositifs de rupture qui exploitent les phénomènes physiques de la superposition et de l’intrication quantique. C’est un domaine en pleine expansion avec de très forts enjeux scientifiques et technologiques. En particulier, la réalisation d’un ordinateur quantique, dont le calcul est intrinsèquement parallèle et permet de traiter en un temps très réduit de grandes quantités d’information, avec des performances inaccessibles au calcul classique, permettrait des approches révolutionnaires pour résoudre certaines classes de problèmes. Parmi les applications possibles :

* La chimie : simuler, in silico, de manière exacte, la structure et le fonctionnement de grosses molécules d’intérêt pour la pharmacologie ou pour l’agronomie. Avec les plus puissants ordinateurs actuels, il est possible de simuler des petites molécules mais il est souvent nécessaire de recourir à de fortes approximations dès que la taille du système étudié augmente.

*

* Le Data Mining : Accélérer la recherche d’une information spécifique dans une vaste base de données.

*

* L’optimisation de procédés de l’industrie 4.0 : trouver une solution optimale dans un système complexe multiparamétrique, comme par exemple la tournée la plus rapide d’un camion de livraison ou ajuster l’offre à la demande sur un réseau électrique très décentralisé.

*

* L’intelligence artificielle : au cours de la phase d’apprentissage d’un système d’IA, telle qu’une reconnaissance d’images, les informations pourraient être simultanément reconnues et non de façon séquentielle comme c’est le cas avec des processeurs classiques (examiner une situation, puis une autre, etc.).

*

*

OÙ EN EST LA RECHERCHE DANS LE DOMAINE DU CALCUL QUANTIQUE ?

La recherche fondamentale dans le domaine de l'information quantique a connu un essor important cette dernière décennie. Les enjeux dans ce domaine et la rupture technologique que présenterait un ordinateur quantique ont incité de grandes entreprises à investir d'importants moyens, en s'associant à des communautés scientifiques, ou en créant leurs propres laboratoires de recherche.

L'association de Google avec l'Université de Californie de Santa Barbara ou la collaboration annoncée sur dix ans du groupe lntel avec l'université technologique de Delft illustrent l'engouement pour cette thématique de recherche et la nécessité de construire un véritable partenariat public-privé sur le long terme. Atos-Bull, leader européen du calcul intensif, s'est aussi positionné activement sur la feuille de route de l'ordinateur quantique en réalisant un émulateur d'ordinateur quantique intégrant finement mémoire et calcul dans un serveur classique optimisé, et en créant une équipe spécialisée en logiciel adapté au quantique.

4 pistes de qubits en compétition dans le monde

Actuellement, 4 types de qubits sont à l’étude dans le monde : le qubit supraconducteur, le qubit silicium, le qubit à ions piégés et le qubit photonique.

* Le qubit supraconducteur est pour le moment la technologie la plus avancée. Il correspond à l’état d’un courant supraconducteur qui traverse une barrière très fine grâce à l’effet Josephson (c’est-à-dire l’apparition d’un courant entre deux matériaux supraconducteurs séparés par une couche d’un matériau non supraconducteur). L’objectif est de créer, à très basse température, une superposition de deux états distincts d’un courant qui oscille à haute fréquence et traverse la barrière en une boucle supraconductrice. Cette technique est utilisée notamment par IBM, Google, Intel, D-Wave et le CEA.

*

* Le qubit silicium, utilise, également à très basse température, la superposition (provoquée par un champ magnétique) du spin (une propriété quantique des particules qui n’a pas d’équivalent en physique classique) d’un électron. De petite taille (généralement 30 nanomètres), les qubits silicium pourraient ainsi être intégrés par millions voire milliards sur une même puce. Ils sont en outre compatibles avec les technologies CMOS (Complementary Metal Oxide Semiconductor : technologie de fabrication des composants électroniques), largement utilisées dans l’industrie microélectronique, ce qui leur donne un avantage compétitif pour la production en série. Cette approche est développée notamment par Intel et le CEA.

*

* Le qubit à ions piégés correspond à des orientations magnétiques d’ions, généralement de calcium, maintenus sous vide. Il fonctionne lui aussi à très basse température. Un laser sert à la mesure et exploite le phénomène de fluorescence des ions excités par le laser. Le magnétisme est utilisé pour l’activation des portes quantiques (qui sont les briques élémentaires d’un circuit quantique, fonctionnant sur quelques qubits). Certes difficilement industrialisables, les ions piégés peuvent s’intriquer plus librement et donc résoudre des calculs complexes plus facilement.

*

* Enfin, le qubit photonique est, quant à lui, lui codé sur de nombreux paramètres indépendants servant à décrire l’état d’un photon (aussi appelés degrés de liberté) : polarisation, couleur, forme spatiale ou temporelle. Les portes quantiques sont réalisées à l’aide de dispositifs optiques avec des filtres à deux couleurs ou polarisants. Il faut un grand nombre de lasers pour piloter l’ensemble, ce qui est contraignant. L’avantage de cette option est que ces qubits fonctionnent à température ambiante.

Une accélération mondiale et un grand nombre d’initiatives publiques et privées

Plusieurs actions majeures à l'étranger (Etats-Unis, Royaume-Uni, Pays-Bas, Danemark) impliquent dès aujourd'hui de très grands industriels (Google, Intel…) et mobilisent des financements de plusieurs dizaines de millions d'euros.

Au niveau européen, un flagship sur l'ingénierie quantique a été décidé en 2016 et a démarré en 2018 avec l'ambition d'amener les technologies quantiques sur le marché. Le financement annoncé est d'au moins un milliard d'euros, apporté par la Commission européenne et les Etats membres sur dix ans.

A l'échelle nationale, Emmanuel Macron a présenté le 21 janvier 2021 le Plan quantique français, dont le Programme et équipements prioritaires de recherche dédié est coordonné par le CEA, le CNRS et l'INRIA.

Un grand nombre de voies à explorer pour espérer lever les verrous conceptuels et technologiques

Un grand nombre de voies de réalisation physique est développé en parallèle. Aucun consensus ni aucun argumentaire robuste n’existe aujourd’hui sur la solution la plus adaptée pour réaliser un ordinateur quantique comprenant plus d’une dizaine de qubits. Tous les systèmes étudiés jusqu’à présent se sont en effet heurtés aux problèmes de décohérence et de complexité rapidement croissante des dispositifs quand le nombre de qubits augmente : le temps de cohérence d’un état intriqué de N qubits est en effet environ N fois plus court que celui d’un seul qubit.

Or, les interactions avec l’environnement ne peuvent par ailleurs être réduites à zéro, car elles sont nécessaires pour appliquer des opérations logiques sur les qubits et en effectuer la lecture. En pratique, il faut donc corriger les erreurs. La seule architecture connue pour ce faire, appelée « code de surface », demande un très grand nombre de qubits physiques par qubit logique.

Ce problème de la correction d’erreurs est donc plus qu’ardu car ses difficultés sont d’ordre à la fois conceptuel et technologique, liant degrés de liberté, interactions, complexité, méthode d’adressage, méthode de mesure, décohérence. A ces questions s’ajoute la vaste problématique de l’algorithmique et de son implémentation pratique dans une architecture donnée (traitement des erreurs, langage de programmation…).

DOCUMENT cea LIEN |

| |

|

| |

|

| Page : [ 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 ] Précédente - Suivante |

|

|

|

|

|

|